Марат Хамадеев

Марат Хамадеев

Доменную адаптацию генеративно-состязательной сети ускорили в пять тысяч раз

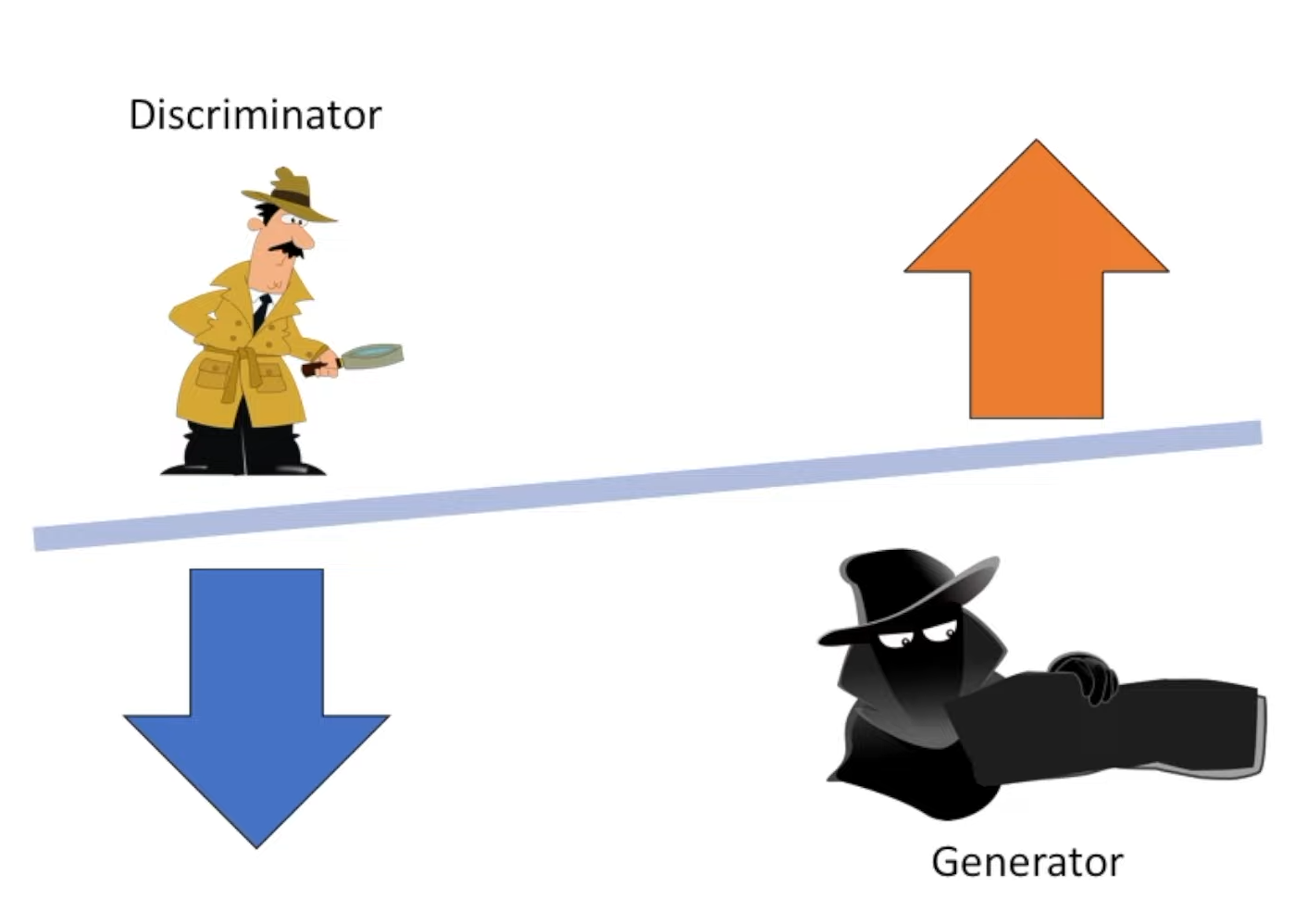

Генеративно-состязательные сети (Generative Adversarial Networks, GANs) показали себя эффективным инструментом для генерации и улучшения изображений, благодаря чему они активно используются для решения самых разных задач в компьютерном зрении. Их работа основана на комбинации двух нейронных сетей — генератора и дискриминатора, — настроенных на работу друг против друга.

Источник: WelcomeAIOverlords / YouTube

Первая генерирует новые образцы на основе исходных, задача второй — распознать, что это подделка. После каждого цикла генерации и распознавания, происходит обновление весов каждой сети на основе общей функции потерь, которая минимизируется генератором и максимизируется дискриминатором. Такая антагонистическая игра позволяет генератору все лучше и лучше подделывать образцы до такой степени, что к концу обучения они становятся неотличимы от реальных образцов.

Для обучения современных GANs требуется десятки и сотни тысяч образцов высокого качества. Это сильно ограничивает применение таких генеративных моделей на домены данных, где собраны такие большие качественные датасеты. Естественным образом возникает задача доменной адаптации, когда мы хотим обучить генеративную модель на узких доменах, для которых нет больших доступных выборок данных. Самый распространенный подход для решения данной задачи — это трансферное обучение (transfer learning, TL). Так называют подход, в котором уже обученная модель адаптируется к новой задаче путем тонкой настройки ее весов.

Как правило в GAN-TL алгоритмах настраиваются все веса предобученной модели. Это оправдано в случае, когда целевой домен находится очень далеко от исходного — например, когда генератор, предварительно обученный на лицах людей, адаптируется к животным или зданиям. В случае же, когда это расстояние не так велико (например, оба домена — это лица, отрисованные в разных стилях), настройка всех весов излишня.

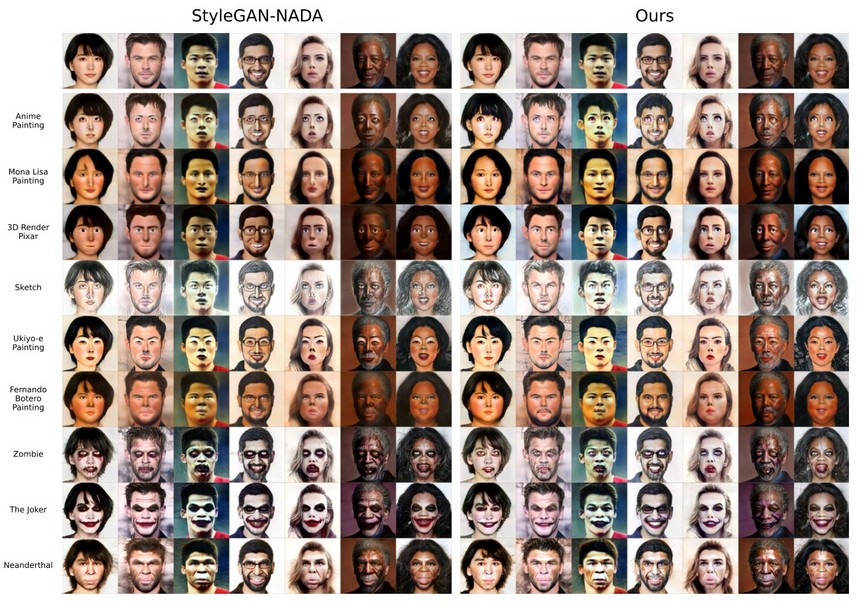

Этот факт побудил Дмитрия Ветрова и его коллег из ВШЭ, МФТИ и AIRI найти более эффективное и компактное пространство параметров для доменной адаптации GAN. Для этого они предложили дообучать лишь небольшой вектор для каждого целевого домена. Этот вектор было предложено внедрить в каждый сверточный слой архитектуры сети с помощью модуляционной операции. Применив новый подход к генеративной модели StyleGAN2, ученые смогли сократить число дообучаемых параметров с 30 миллионов до 6 тысяч без потери визуального качества генерации изображений.

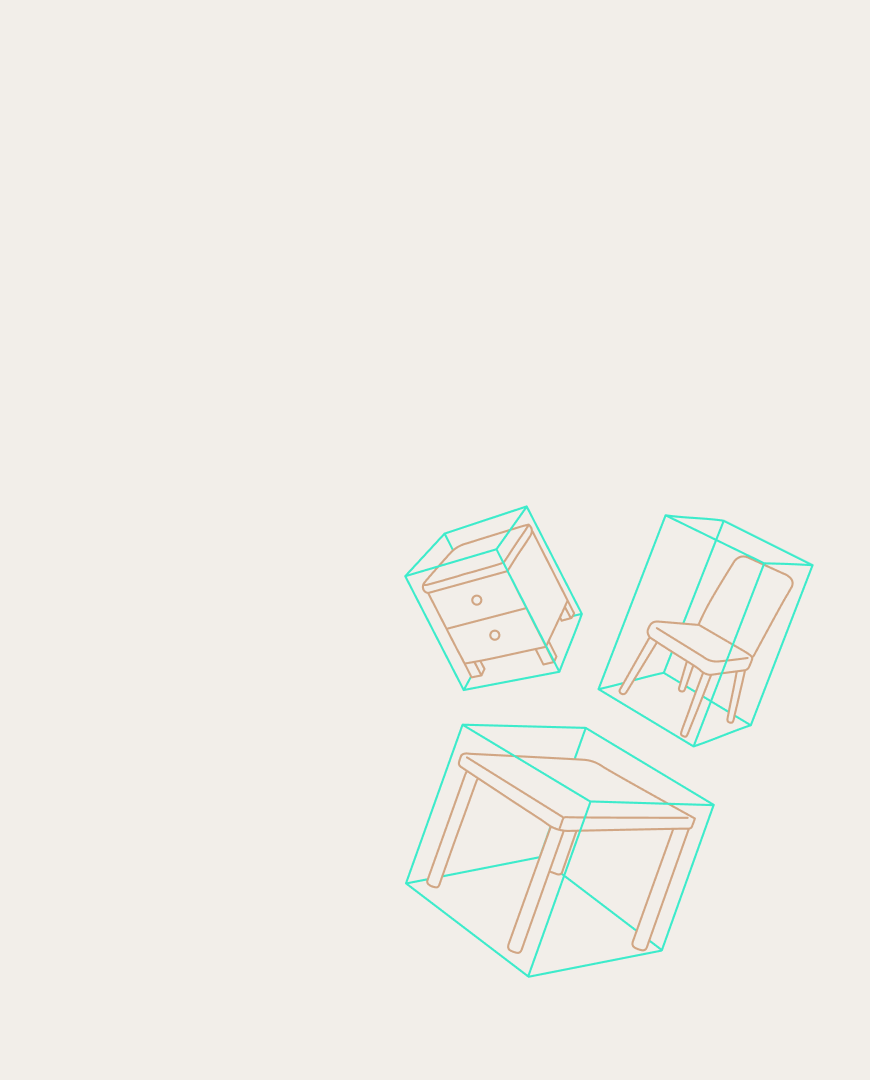

Сравнение генерации с помощью исходного метода StyleGAN-NADA и его модификации, предложенной авторами

Если обучать только такой доменный вектор, то домен генерируемых картинок меняется так же хорошо, как если бы мы дообучали все параметры нейронной сети. Это кардинально снижает число оптимизируемых параметров, так как размерность такого доменного вектора всего 6000, что на порядки меньше, чем 30 миллионов весов нашего генератора. Также это позволило предложить нам модель, которая предсказывает такой вектор только по описанию целевого домена.

Такое существенное сокращение сделало возможным решение проблемы мульти-доменной адаптации GAN. Сейчас для каждого домена исходных образцов требуется независимое обучение. Результат авторов позволил ввести в алгоритм гиперсеть, которая умеет подстраивать оптимизированный вектор параметров StyleGAN2 под каждый случай уже на этапе применения. Она получила название HyperDomainNet.

Главное преимущество мульти-доменного подхода на основе HyperDomainNet заключается в сокращении времени обучения, поскольку вместо точной настройки n отдельных генераторов ученые обучают одну гиперсеть адаптироваться к n доменам одновременно. Новшество продемонстрировало и другой положительный эффект: когда n стало достаточно большим, алгоритм смог адаптировать GAN к доменам, которые не были представлены в обучении.

Подробнее с работой можно ознакомиться в статье, опубликованной в сборнике трудов конференции NeurIPS 2022.