Марат Хамадеев

Марат Хамадеев

Диффузионные модели научили точнее и быстрее редактировать изображения

В последние годы диффузионные модели доказали свою успешность в text-to-image задачах, то есть в создании изображений на основе текстового описания. Однако помимо рисования с нуля, полезным было бы научить такие модели редактированию уже существующих изображений. Несмотря на достигнутый прогресс, разработчикам новых моделей пока сложно найти баланс между успешностью редактирования и сохранностью той части картинки, которую менять не следует.

Существуют разные подходы к этой задаче. Например, исследователи используют дообучение модели на входном изображении, чтобы она сохранила его структуру и нужные детали, и не потеряла их в ходе редактирования. Также можно модифицировать алгоритм диффузии либо на этапе зашумления, либо на этапе реконструкции. Но ни один из существующих подходов не достигает приемлемого компромисса между скоростью, универсальностью и качеством.

Исследователи из группы «Контролируемый генеративный ИИ» лаборатории FusionBrain AIRI вместе с коллегами из Университета Нового Южного Уэльса и Университета Констрактор в Бремене предложили свой способ достичь такого компромисса. В качестве отправной точки они выбрали кеширование внутренних представлений исходных изображений при forward этапе и подстановке их при редактировании на backward этапе. Однако вместо явной подстановки учёные предложили добавлять к функции потерь специальное слагаемое, которое направляет генерацию в желаемую сторону. Новый метод получил название Guide-and-Rescale.

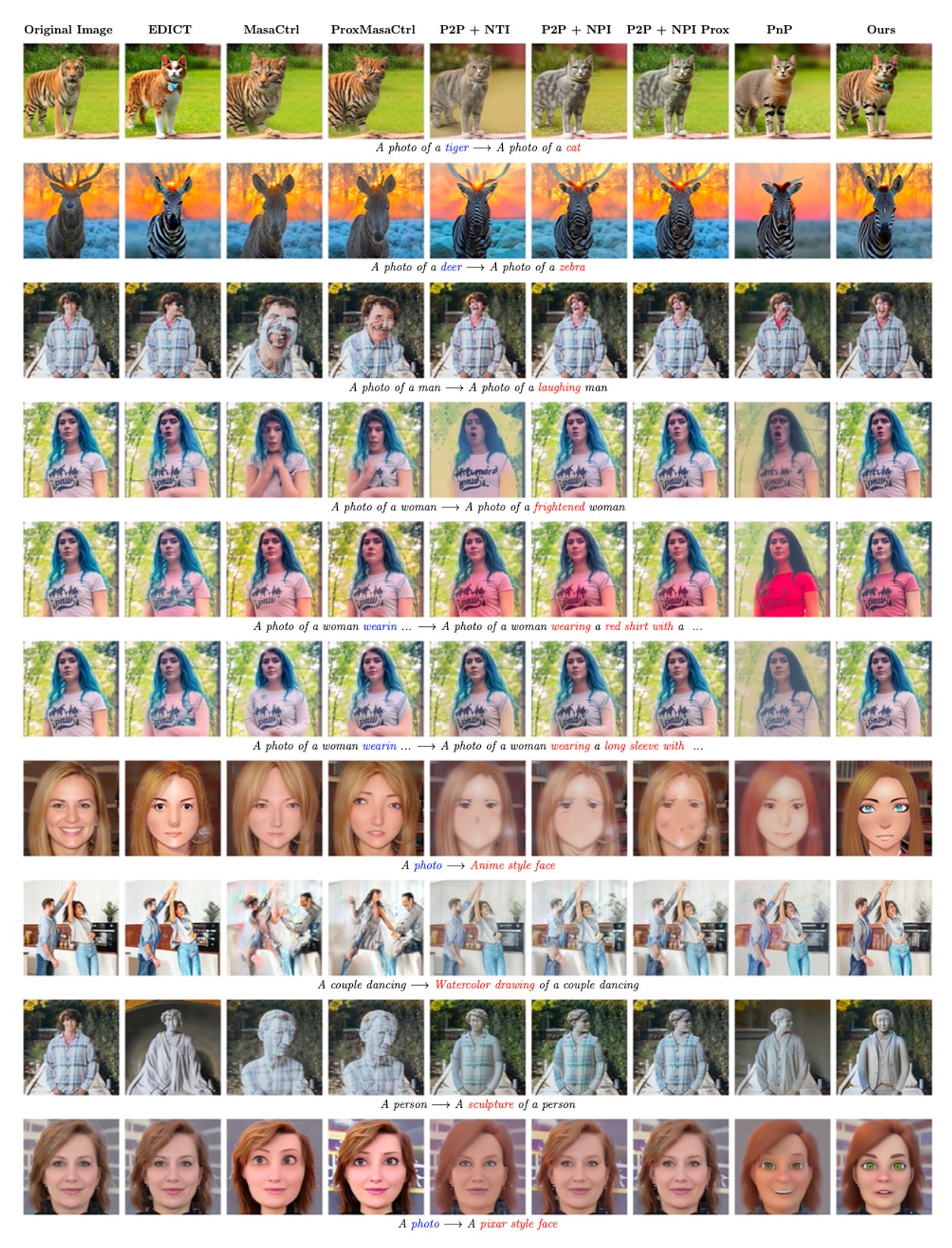

Авторы проверили свой метод на четырёх различных задачах: изменение внешности и одежды человека, изменение эмоций, замена животного и глобальная стилизация. Тем же испытаниям они подвергли несколько существующих сегодня подходов к редактированию, лежащих в открытом доступе. В ходе экспериментов подход Guide-and-Rescale показал более стабильные результаты и позволил достичь лучшего компромисса между качеством редактирования и сохранением структуры исходного изображения.

Визуальное сравнение нового метода с бейзлайнами при различных типах редактирования

Также исследователи провели оценку с помощью живых людей. Они опросили 62 пользователя, которые ответили в общей сложности на 960 вопросов. Этот этап также подтвердил, что Guide-and-Rescale дает лучшие результаты по качеству редактирования при сохранении областей, которые не должны остаться неизменными.

Статья с описанием метода и результатами была представлена на конференции ECCV 2024 в Милане. Группа выложила код на GitHub, а также демо на HuggingFace.